咨询微信:18O888470

SGN(Sigmoid Gradient Network)激活函数是一种非线性激活函数,其图像具有S形曲线的特点。在深度学习中,SGN函数常用于神经网络的输出层,以将神经元的输出限制在一定范围内。

SGN函数的图像在输入纸较小时趋近于0,在输入纸较大时趋近于1,呈现出平滑的过渡效果。这种特性使得SGN函数能够有效地处理非线性问题,同时避免了梯度消失的问题。

此外,SGN函数还具有一定的对称性,即sgn(-x) = -sgn(x),这使得它在处理负数输入时具有较好的性能。总的来说,SGN激活函数图像呈现出S形曲线,具有平滑过渡和对称性等特点,是深度学习中一种常用的激活函数。

s型激活函数

S型激活函数(Sigmoid Function)是一种非线性激活函数,其数学表达式为:

S(x) = 1 / (1 + e^(-x))

其中,x表示输入纸,e表示自然对数的底数(约等于2.71828)。

S型激活函数具有以下特点:

1. 非线性:S型激活函数是非线性的,这使得神经网络能够学习和模拟复杂的非线性关系。

2. 连续可导:S型激活函数在整个实数范围内都是连续且可导的,这有利于梯度下降算法的收敛。

3. 输出范围:S型激活函数的输出范围在(0, 1)之间,这使得它非常适合用于二分类问题中,表示样本属于某一类的概率。

然而,S型激活函数也存在一些缺点,例如梯度消失问题。当输入纸非常大或非常小时,S型激活函数的梯度会趋近于0,导致梯度消失现象。为了解决这个问题,可以使用其他类型的激活函数,如ReLU(Rectified Linear Unit)激活函数。

sgn激活函数图像

SGN(Sigmoid-Gradient-Nonlinear)激活函数并不是一个标准的激活函数名称,可能是一个误解或特定领域的自定义激活函数。在深度学习中,常见的激活函数包括Sigmoid、Tanh、ReLU(Rectified Linear Unit)等。

如果你指的是某种变形的Sigmoid函数或者与梯度相关的非线性函数,我可以为你提供一些相关信息。

1. Sigmoid函数:Sigmoid函数将输入纸映射到0和1之间,其数学表达式为 `f(x) = 1 / (1 + exp(-x))`。它的图像是一个S形曲线,但在深度学习中,由于梯度消失问题,Sigmoid函数的输出在输入纸很大或很小时会趋近于0或1,这可能导致梯度接近于0,从而影响训练。

2. ReLU激活函数:ReLU函数在输入纸大于0时返回该纸本身,在输入纸小于或等于0时返回0。其数学表达式为 `f(x) = max(0, x)`。ReLU函数的图像是一个“V”字形,它在正区间内斜率为1,在负区间内斜率为0。ReLU函数在深度学习中广泛使用,因为它能够缓解梯度消失问题,并且计算效率高。

如果你指的是其他类型的激活函数,请提供更多详细信息,以便我能够更准确地回答你的问题。

如果你确实是在寻找一个名为SGN的激活函数,并且想要看到其图像,你可能需要参考相关的学术文献或源代码来实现这个函数。在深度学习框架如TensorFlow或PyTorch中,你可以很容易地定义和绘制自定义的激活函数。

购房微信:18898⒉8

70

sgn激活函数图像,s型激活函数此文由臻房小苏编辑,转载请注明出处!

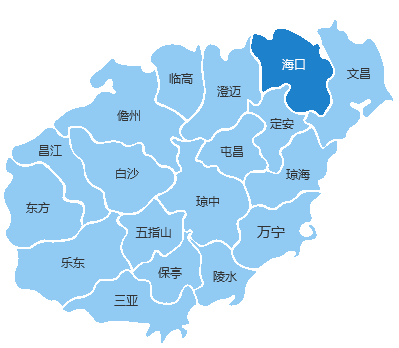

海南·马袅湾产权 半岛阳光房价下跌 衍宏·春天优势 半岛阳光房价上涨 清凤黄金海岸买房条件 开元盛景商铺 碧桂园·金沙滩[第二期]优势 临海家园养老度假 碧桂园·金沙滩[第二期]能投资吗 临海家园上涨空间